「Ultimate NN Programming with Python」の著者

Why GEN AI Boom Is Fading And What’s Next?

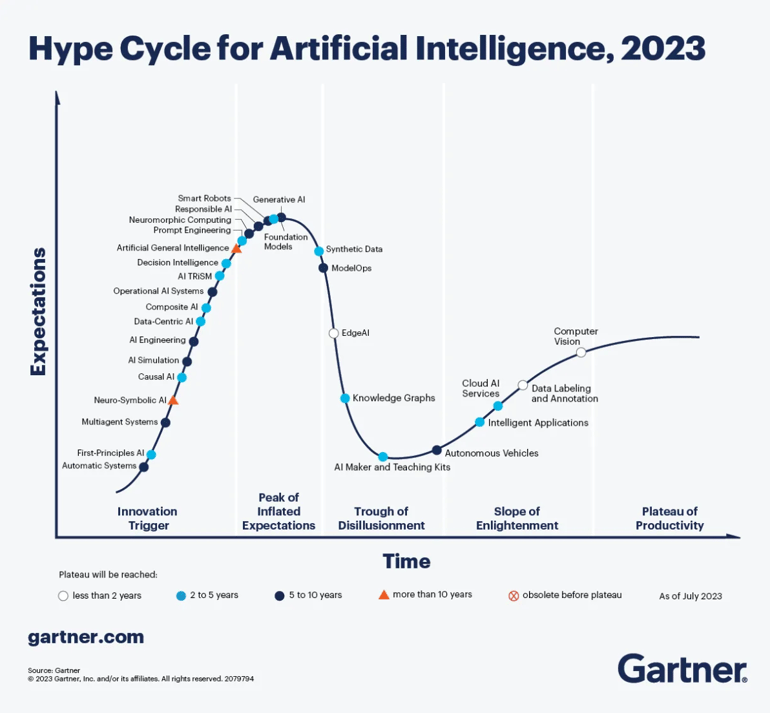

過去数十年でAIほど騒がれたものはない。その多くはノイズだが、いくつかの優れたブレイクスルーもある。AIのハイプサイクル(訳注 特定の技術の成熟度、採用度、社会への適用度を示す図)は新しい現象ではなく、AIに限った話でもない。

私たちは多くの新興テクノロジーでこの種の現象を見てきた。

ChatGPTのリリースですべてが大きく変わり、AIはあらゆるビジネスの話題となったが、これらのノイズは必ずしも良いことではない。このハイプの中で、多くの重要なことが見落とされている。今回は、AIを使ったテクノロジーとビジネスの観点から、何が起きているのかを見ていく。

この記事では特に、生成AIに焦点を当てる。

LLMには主に3つの見方がある。それぞれ詳細を見ていく。

ポジションI(懐疑論)

Chomskyのような少数の科学者は、LLMは高度に発達した統計的ツールであり、知性とはまったく同等でないと見ている。これらの機械は非常に多くのデータを見ているため、私たちが思いつくどんな質問に対しても回答を与えられる。数学的には私たちが思いつくあらゆる質問に対して、条件付き確率を計算している。

私の見解:ここでの欠陥は、データモデリングが、真の理解ではないにせよ、認知の一部の側面を模倣できることを過小評価していることかもしれない。私たちは常に様々な感覚によってデータを与えられており、理解と理解の模倣とを区別するには、他のタイプの知性の開発が必要かもしれない。

次の論文では、LLMの挙動がN-gramの統計的規則でどれだけ説明できるかについて光を当てている:Understanding Transformers via N-gram Statistics

ポジションII(希望的洞察)

Ilya Sutskever(ChatGPTの開発者)とHintonは、LLMが人間の経験を反映した内部モデルを開発したことを示唆している。インターネット上のテキストは人間の思考と経験を表現したものであり、データの次の言葉を予測するように訓練させることにより、人間の世界と経験を理解するようになった、と言っている。LLMが本当の意味で知的になり、あるいは知的に見えるようになり、人間と同じように世界モデルを作り上げたと言っている。

私の見解:これはLLMの深さを誇張しすぎているかもしれない。複雑なデータ処理を本物の理解力と勘違いし、意識的な経験や自己認識がこれらのモデルにはないことを見落としている。もしLLMがこのような内部世界モデルを構築しているのであれば、なぜLLMはこのような内部世界モデルと矛盾しないはずのかなり単純な作業で惨敗するのか?

ポジションIII(実用主義)

LeCunやKambhampati のような多くの科学者は、LLMを強力な補助手段と見ており、人間のような知性を持つ存在とは見ていない。LLMは記憶や検索能力には優れているが、真の意味での推論や理解には欠けている。LLMを擬人化したり、人間のような知性を持っていると勘違いすべきではないと考えている。LLMは 「認知補助具」として優れており、文字を書くなどの作業を補助するが、人間のシステム2思考に似た深い推論プロセスには欠けている。

注:私たちは、現在のLLMは、システム1の知能を持っていると考えている。だからこそ、線形であれ二次関数であれ指数関数であれ、どの問題もほとんど同じ時間で解けるのだ。

LLMは人間のシステム1(反射的行動)に似ているが、システム2(熟慮的推論)の要素を欠いている。LLMには深い熟慮的推論や、第一原理からの問題解決能力がない。

将来のAIの進歩は根本的に異なる原理に依存するものであり、AGIの出現は単にスケーリングによって達成されるものではないと考えている。LeCunは、LLMに取り組むな、とさえ言っている。

私の見解:LLMをめぐるすべての開発から生まれたいくつかのコンポーネントは、間違いなく次世代システムの一部になるだろう。何が将来のシステムに採用されるのか、正確には分からないが、過去の進歩の名残は間違いなくその一部になるだろう。

システム2(Img Src)

以下の3つのブログで、

トレンドの推定は根拠のない憶測

すべての指数関数は、隠れたシグモイド関数だ。

この引用は分野全体を要約している。

CPUクロック速度の経時変化。Y軸は対数。(出典)

有名な2つの例は、2000年代のCPUクロック速度と、

飛行機の速度記録の変遷。

1976年のSR-

合成データは、

しかし、これは誤解の上に成り立っていると我々は考えている。

2016年に囲碁の世界チャンピオンを破ったAlphaGoや、

現在のシステムの良し悪しはわからない?

コストを考慮しないAIエージェントの正確性測定は役に立たない

現在の最先端のエージェントアーキテクチャは複雑でコストがかか

与えられたタスクに最適なシステムを特定することが目的であれば

LLMは確率的である。モデルを何度も繰り返し呼び出し、

あるタスクでは、

コーディングタスクにおけるAlphaCodeの精度は基礎とな

したがって、エージェントの有用な評価は、「

実際、

最も目立った結果は、HumanEvalのエージェントアーキテ

データが汚染された論文はすでに数多く出回っている。

https://arxiv.org/pdf/2405.

だから、現在のシステムがどの程度優れているのか、

LLMの関数はいかに惑わされているか:https://

根本的な問題は別のところにある、我々には科学的理論がない

AIの初期の創始者たちは、

誤解しないでほしい。

しかし今、私たちはこの5つのポイントでは解決できない、

問題は、

What’s the Magic Word? A Control Theory of LLM Prompting

そしてもうひとつはClaude 3のチームのものだ。

私たちは、

私は、

なぜディープラーニングがこれほどうまく機能するのか、

新しいタイプの対称性を発見でき、

これらすべてを行える単一のアルゴリズムは存在しないと思うが、

資金問題

AIに関する最大の問題は資金である。多くの人々は、

多くの企業が、AGIを達成するという目標を公言している。

資金面をもう少し分析してみよう。親愛なるサム・

ユニバーサル・ベーシック・インカム(UBI)

ロボットが欲望を持った消費者にならない限り、

仮定のAGIユースケースのことは忘れることだ。今でさえ、

新興企業の半分はOpenAI APIのラッパー(※訳注 既存のコードを囲んで機能を追加するコード)に過ぎず、

AIバブル崩壊の原因は?

AIバブル崩壊には、以下のようないくつかの要因が考えられる:

- 持続不可能な評価。過大評価されたAI企業には、

その高い評価を正当化するだけの収益や成長性がない可能性がある 。 - 収益性の高い収益源の欠如。多くのAI企業は、

AI投資による大幅な収益増加を示すことができていない。 明確な収益化戦略がなければ、 多額の支出を続けることは持続不可能になる可能性がある。 - 規制上の課題。AIの安全性、倫理、

データプライバシーに関する監視や規制の強化は、 AI開発の勢いを鈍らせ、 企業の評価に影響を与える可能性がある。 - 景気後退。より広範な景気後退は、

AIへの投資の減少につながり、 株価の下落をさらに悪化させる可能性がある。

決してAIで企業が儲からないと言っているわけではないが、

もうひとつ忘れてはならないのは、

従業員の77%が、AIによって仕事量が増加し、

https://www.forbes.com/sites/

最近、Upwork Research Instituteは、世界のC-suite幹部、正社員、

経営幹部の96%

さらに追い打ちをかけるように、

この調査がどれほど正確なものか、

AIの次に何が起こるのか?

スケーリングによる能力向上がこれ以上見込めない可能性と一致す

汎用性を二項対立で捉えるのではなく、

つまり、AIの分野で起こりうる次の段階は、

私は純粋に、

このような取り組みで大きな進歩を遂げた興味深い論文を、

What’s the Magic Word? A Control Theory of LLM Prompting

Understanding Transformers via N-gram Statistics

多くのアプリケーションにとって、信頼は重要な要素であり、

正直なところ、AGIは必要ない。必要なのは、人間の知能を増強

AI製品やサービスの無分別な普及は、

このブログの最後に2つの例を挙げる。一つはAIの友達やガール

もう一つは、教育におけるAIだ。

お読みいただきありがとうございました!この記事を読んで、

このような記事を書くにはかなりの努力と時間が必要です。

英語版参照元:

https://medium.com/aiguys/why-

DMNでは、他にも様々なブログを「DMN Insight Blog」にて配信しております。

定期的に記事をご覧になられたい方は、ぜひご登録をお願いいたします!

→「DMN Insight Blog」メールマガジン登録